Tesla ha anunciado que comenzará a prescindir del uso de sensores ultrasónicos que actualmente todavía utiliza en el Autopilot en favor del sistema Tesla Vision, que tan solo utiliza las cámaras para mapear el entorno. Una decisión que parece ir en contra de lo que el resto de la industria está desarrollando que se basa en las cámaras, los sensores y sobre todo el radar LiDAR para alimentar de datos el software que toma las decisiones e informa al conductor.

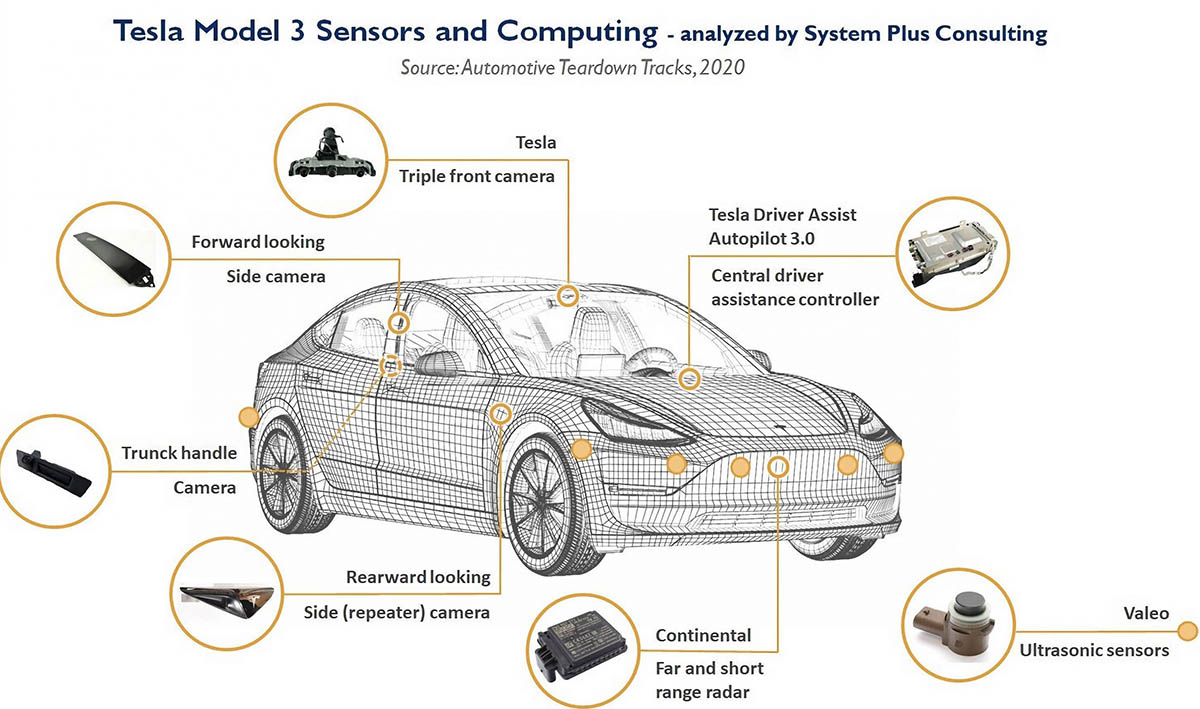

El año pasado, Tesla ya anunciaba que dejaría de implementar el radar para su sistema Autopilot, iniciando así una transición al nuevo sistema Tesla Vision basado únicamente en cámaras, y que empezaría a utilizarse en los Tesla Model 3 y Model Y fabricados a partir de mayo de 2021. Originalmente, el conjunto de sensores y cámaras que formaban el hardware del piloto automático eran todo lo necesario para lograr, eventualmente, la capacidad de conducción autónoma total. Implementados en todos sus coches, incluía ocho cámaras, un radar frontal y varios sensores ultrasónicos que rodeaban al vehículo.

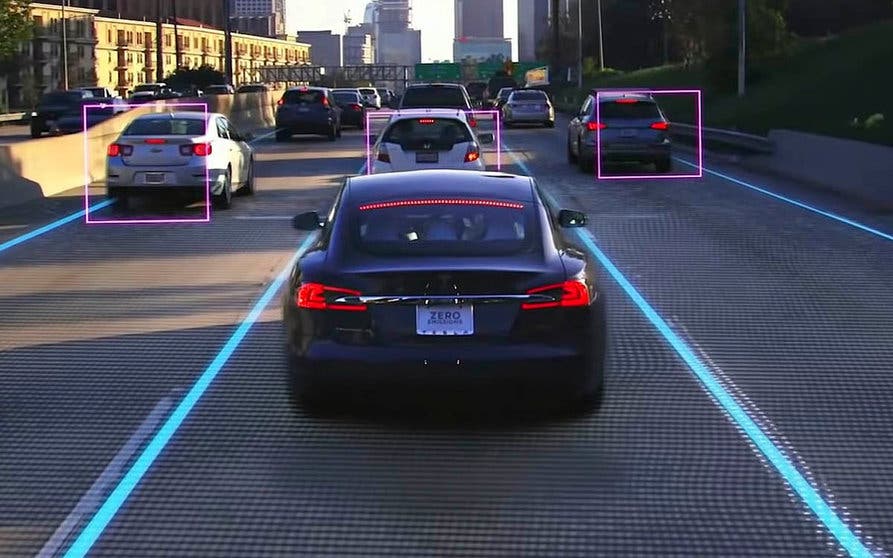

La transición al nuevo sistema Tesla Vision significa cambiar el concepto original para utilizar solamente la visión virtual por computadora basada únicamente en los datos que envían las cámaras y prescindiendo de sensores y radares.

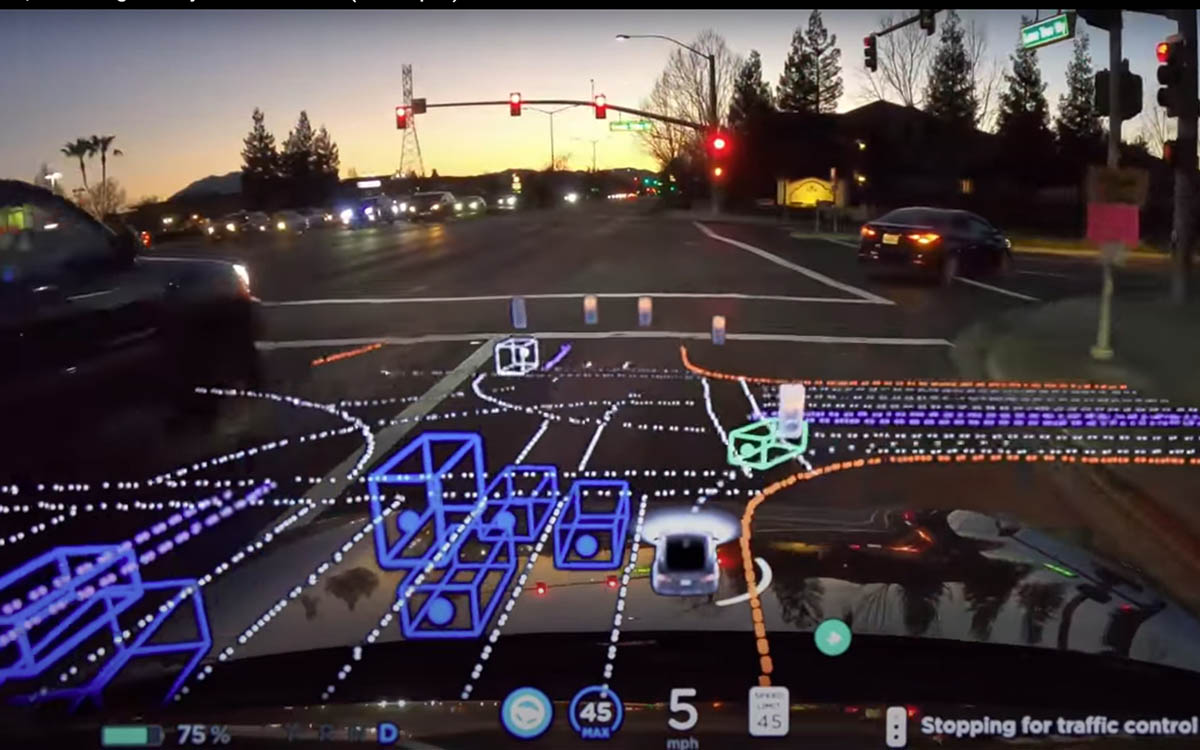

La lógica hace pensar que cuantos más datos sea capaz de recoger el sistema más seguro será, puesto que la información se podrá contrastar para evitar errores. Sin embargo, la idea de Tesla es seguir el proceso natural que emplea el cerebro humano que "navega" con un sistema que solo utiliza la visión espacial y en la inteligencia. Las cámaras capaces de ver el entorno completo, el ordenador capaz de interpretarlo y las redes neuronales capaces de aprender mediante inteligencia artificial y datos son los "sustitutos tecnológicos" de esos sentidos humanos. Tesla cree que los datos del radar y de los sensores podrían ser incluso contraproducentes porque podrían contaminar el sistema.

El cambio anunciado por Tesla el año pasado tenía sus consecuencias directas sobre algunas de las funciones del Autopilot de Tesla, que se limitarán en los vehículos que no incluyan radar. Así, por ejemplo, la velocidad máxima a la que actuaba la dirección automática de los vehículos con Tesla Vision era de 120 km/h (75 mph). Ahora Tesla anuncia que va un paso más allá eliminando los sensores ultrasónicos reemplazándolos por la tecnología de visión de las cámaras: "Hoy damos el siguiente paso en Tesla Vision al eliminar los sensores ultrasónicos (USS) del Model 3 y del Model Y fabricados en Estados Unidos. Continuaremos con esta decisión a nivel mundial en estos mismos modelos durante los próximos meses, seguidos por el Model S y el Model X en 2023".

Los sensores ultrasónicos se utilizan principalmente para la detección de objetos cercanos, sobre todo en maniobras a baja velocidad como el estacionamiento (automático o manual) y las advertencias de colisión. Tesla ha explicado como sus redes neuronales capaces de "ver" a través de las cámaras reemplazan a estos sensores: "Junto con la eliminación de los sensores USS, lanzamos nuestra red de ocupación basada en visión, actualmente utilizada en la versión beta de Full Self-Driving (FSD), para reemplazar las entradas generadas por estos USS. Con el software actual, este enfoque brinda al Autopilot un posicionamiento espacial de alta definición, una visibilidad de mayor alcance y la capacidad de identificar y diferenciar entre objetos. Al igual que con muchas funciones de Tesla, nuestra red de ocupación seguirá mejorando rápidamente con el tiempo".

El software actual limita provisionalmente algunas funciones que sí son posibles con el uso de sensores ultrasónicos. Durante el breve período de tiempo durante esta transición, los vehículos Tesla Vision que no estén equipados con USS se entregarán con algunas características temporalmente limitadas o inactivas: asistencia al estacionamiento (Park Assist), el estacionamiento automático (Autopark), la función Summon manual y también la inteligente (Smart Summon). En un futuro próximo, una vez que estas características alcancen el rendimiento parejo con los vehículos actuales, se restaurarán a través de una serie de actualizaciones de software inalámbricas.

Mantiene funcionando como hasta ahora la advertencia de colisión frontal, el frenado de emergencia automático, a alerta de cambio de carril con evitación, la prevención de salida del carril, la mitigación de la aplicación incorrecta del pedal, la luz larga automática, la advertencia de punto ciego, la dirección automática el cambio automático de carril, la navegación en piloto automático y el control sobre los semáforos y las señales de STOP.